公平性

想找份理想工作?你得先通過AI這一關

想找份理想工作?你得先通過AI這一關

編譯/劉大維

當越來越多的企業採用AI徵才,如何寫一份機器看得懂的履歷,成為網路時代必備的求職技能。

AI的參與式設計正義

AI的參與式設計正義

編譯/江彥成、黃思齊

AI的判斷是否會比人類更公平,讓世界變得更美好?參與式設計是否讓我們又向公平AI更進一步?

偏差的模型比想像中致命

偏差的模型比想像中致命

編譯/劉大維

當前這個萬物聯網的世界每天都產生海量的大數據,用來訓練機器的資料不虞匱乏,但如何篩選及處理才是問題所在。因為用來訓練的資料,關係到模型的成效表現。使用偏差、失衡的資料來訓練機器,更會有災難性的後果。

性盲信用評比中的性別偏見

性盲信用評比中的性別偏見

編譯/陳宣豪

2019年11月的某個清晨,紐約金融服務部對高盛集團展開一項性平調查。原因是David Heinemeier Hansson(網頁應用開發框架Ruby on Rails的原創者)在Twitter上發文,指控蘋果公司信用卡Apple Card的核卡制度不利於女性申辦人。在自己與妻子同時以聯合納稅申報表申辦的前提下,核發給自己的刷卡額度竟是妻子的20倍!對此,委託管理Apple Card的高盛,在聲明中強調內部信用評估所使用的演算法完全不考慮「性別」這項因子。這凸顯了AI公平性這項議題上的一個弔詭:當電腦完全不知道某人性別時,如何去歧視?

打造對身障者友善的AI

打造對身障者友善的AI

編譯/陳宣豪

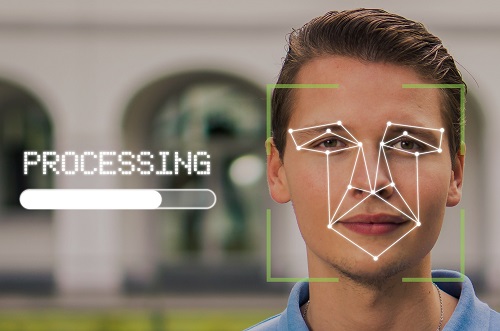

人臉辨識系統無法辨識黑人女性,或將黑人視為潛在罪犯,種種AI表現出針對特定種族或性別的認知偏差,已引發廣泛的關注。即使研究人員已努力設法解決這些潛在的社會歧視問題,但仍有部分弱勢團體往往在這類討論中被忽略,尤其肢體或精神障礙者。

偏見如何形成?由人類到AI

偏見如何形成?由人類到AI

編譯/黃柏瑋

偏見,針對特定個體或族群產生難以事實或其他跡證撼動的既定印象,看似一種涉及高等認知能力、專屬於人類的社會現象。即使許多電腦演算法的公平性受到質疑,但多被歸因於訓練集中無法完全剔除的人類「偏見」所致,演算法最多只是忠實反映人類社會中既有的種族或性別問題。然而英國卡地夫大學與美國麻省理工學院共同主持的一篇研究,卻認為看似「不經大腦」的「有樣學樣」或許正是促使偏見形成的禍首。

公平公正的AI,可能嗎?

公平公正的AI,可能嗎?

編譯/ 黃柏瑋

在這逐漸自動化的世界裡,許多金融或政府機構已開始利用AI來審查貸款、社會福利、簽證,甚至於職缺應徵資格。但AI就像是一面鏡子,如實地反映訓練集中的資料,也難免透露出背後人類固有的偏好與社會不公,導致演算結果對弱勢族群的歧視,甚至因行政效率的提升,加速剝削的發生。「演算法的公平性與透明性」於是逐漸受到重視,歐盟更試圖將「可解釋AI」編入法律,要求所有「個人化自動決策」(Automated Individual Decision-Making)賦予用戶請求解釋的權利,並確保訓練數據的中立,不得讓任何用戶的權益因此受損。只是,如「黑盒子」般神秘又複雜的神經網路,其判斷依據可能就連開發者都理不清。