真假難辨?談AI偽造影像帶來的危機

真假難辨?談AI偽造影像帶來的危機

講者/許志仲(國立屏東科技大學資訊管理系助理教授)|彙整/葉珊瑀

整理自2020.03.13〈AI報你知.同名〉

近來DeepFake一詞一躍成為媒體的新寵兒。運用這種技術,可以仿造、合成任何政治人物或偶像藝人的影像,讓他們說出不曾說過的話,以達到特定政治目的。什麼是DeepFake?又能如何識破造假影像?

生成模型的演變

DeepFake相關技術最早的雛型是由「自動編碼器」(AutoEncoder)建構而成的生成模型(generative model)。自動編碼器分為兩部分:資訊編碼與特徵解碼。前者目的是當我們呈現一系列資料給模型時,編碼器能夠從中找到一些重要的特徵,以這些特徵(較少的資料)來代表原始複雜的資料,達到簡化的目的。由於我們事前並不知道以怎麼樣的方式,或以哪些特徵,可以最完整地代表整筆資料,所以自動編碼器其實要在幾乎沒有人類的指導下完成這項任務,屬於機器學習中「非監督式學習」(unsupervised learning)的範疇,而特徵抽取(feature extraction)也是非監督式學習常見的用途之一。

特徵解碼器則反其道而行,嘗試由特徵還原出完整的原始資料,將重建出的資料與原始資料相比對,便可驗證編碼器所提取出的特徵是否有足夠的代表性。這項任務其實比想像中來得困難許多。假設今天小美、小明與阿華三人每月的薪資依序為:30k、40k與50k,我們可以很輕易地計算出三人的平均薪資為40k,並以該數字(特徵)來代表三人的薪資水平(整筆資料);然而今天若僅告知你三人的平均月薪是40k,希望你能依此線索回推出三人的原始薪資,卻是難上加難。

除此之外,這類生成模型其實還有其他的缺陷,例如:所生成(重建出)的影像仍侷限於原始的訓練資料,沒有太大的變動空間;再者,當我們在比對重建出的影像與原始影像時所使用的數學方法,其實無法如實反映人類的主觀視覺感受──某些在數值上近乎完美的重建影像,在人類眼中看來就是不夠好。這也催生了直至2014年方才提出的新模型──生成對抗網路(Generative Adversarial Network,GAN)。

「對抗」,生動描述了GAN中「生成器」(generator)與「識別器」(discriminator)兩個子網路之間的關係:生成器所產生的偽造影像會與真實影像一起接受識別器的評判,直到連識別器也無法區辨真偽時,生成器便也達成它的目的──成功產生一張真假難辨的偽造影像。

GANs可以運用的地方很多。例如當訓練圖像辨識模型時,如果可以獲得的資料過少,便可藉由GANs生成模擬資料來增加樣本數;另外如資料的修補、影像品質的強化、提升解析度、由文字生成影像、風格轉換、人物穿搭轉換等,都是GANs的應用。然而科技總免不了被有心人士誤用,先前提到的DeepFake便是一例。

影像鑑偽

過去透過修圖軟體人工變造的影像,可以透過光源的變化、色澤差異及人物表情與環境是否違和來鑑別真偽;同樣地,目前的DeepFake雖然早已克服上述手動修圖常見的缺陷,但仍無法做到十全十美,在某些生物特徵,如虹膜、髮際處等依然留有破綻。有些人便想到以「以毒攻毒」的方式,以深度學習對抗深度學習,這類辨偽技術被稱為anti-GANs(又稱Video forensics)。

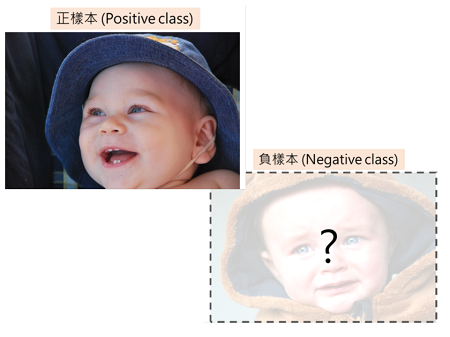

一開始的anti-GANs研究,通常是針對少數,甚至單一GAN模型。只是這樣的作法,隨著相關研究與模型數量攀升,顯得緩不濟急。然而許教授想到了一個方法:照理來說,不同DeepFake影像特徵之間的差異,應該小於任一偽造影像特徵與真實影像特徵之間的差異。當今天要分辨一個未知樣本的真偽時,只要比較該樣本與另一偽造影像特徵之間的差異(A),以及與一真實影像特徵之間的差異(B),若A<B,則幾乎可以確定該樣本亦為偽造影像。

如此便能掌握各個DeepFake影像之間共通的瑕疵,一個通用的DeepFake檢測器(DeepFD)不無可能。許教授與團隊依此原理所打造出的anti-GAN模型,最終取得85%的準確率。然而隨著AI發展日新月異,矛與盾之間你來我往的相互攻防之下,難保能一直佔上風。

倫理問題

這令人不禁擔憂:現階段的DeepFake技術還存在可見的瑕疵,只要一個人細心觀察,至少還有五、六成的準確率。若是未來相關技術持續發展,人類連五、六成的把握也沒了,應該如何是好?又該如何防範?

AI的研究倫理近幾年於是成了熱門話題。目前美國已有相關法案,規定相關程式碼必須開源、模型要公開,以防患於未然。

(本文為教育部「人工智慧技術及應用人才培育計畫」成果內容)

前一篇文章

前一篇文章 下一篇文章

下一篇文章 小數據大智慧

小數據大智慧  革命性科技:量子電腦

革命性科技:量子電腦  數學能阻止恐攻嗎?

數學能阻止恐攻嗎?  音樂與人工智慧的無限可能—專訪楊奕軒

音樂與人工智慧的無限可能—專訪楊奕軒  智慧製造讓生活更加便利

智慧製造讓生活更加便利  擺脫負樣本的限制

擺脫負樣本的限制  讓機器自己學習語音的實踐者—專訪李宏毅

讓機器自己學習語音的實踐者—專訪李宏毅  談談AI的「低潮期」─演算神經醫學

談談AI的「低潮期」─演算神經醫學