教機器人說不(1/2)

教機器人說不(1/2)

撰文/Gordon Briggs、Matthias Scheutz|譯者/周坤毅

轉載自《科學人》2017年3月第181期

先別擔心機器人會違抗人類命令,因為不懷好意的主人與誤判指令將造成更大威脅。

重點提要

- 隨著高度自動化的智慧機器越來越普及,目前人為疏失會比超級人工智慧(AI)帶來更大的風險與挑戰。

- 研究人員已經開始教導機器人簡單的語言能力與AI,希望它學會在何時與如何對人類說「不」。

- 編譯入機器人推論機制中的「適切條件」檢查表,能幫助它決定是否應該執行人類的特定指令。

知名科幻電影「2001太空漫遊」(2001: A Space Odyssey)描述未來具有高度人工智慧(AI)的機器不再聽從人類指揮,擁有自我意識的電腦「哈兒」控制了太空船並殺死大部份船員。當其中一名返回太空船的太空人要求哈兒打開艙門時,它用令人膽寒的冷靜口吻回答:「抱歉,戴維,恕難照辦。」而在最近的科幻驚悚電影「人造意識」(Ex Machina)中,美麗的機器人艾娃誘使一位不幸的年輕人協助殺死創造它的納森。它的陰謀應驗了納森早先的悲觀預言:「有一天,AI會回頭看我們,如同我們看著非洲平原上的骨骸化石一樣。人類就像使用原始語言與工具的直立人,遲早都會滅亡。」

儘管機器人的造反還只是大眾的幻想,我們研究團隊更關注AI對現實生活的影響。相信在不久的未來,能與人類互動合作的機器人,將進入生活中每一個層面。目前已有語音控制的個人機器助理原型,可連結並監控個人電子裝置,負責管理家中的門鎖、燈光,調節室內溫度,甚至讀床邊故事給小孩聽。協助家庭雜務並照顧病人或年長者的機器人很快也將成真,有些居家修繕販賣店已配備能在貨架之間滑行並檢查庫存的機器人原型,能執行裝卸貨物或分類材料等簡單生產線工作的活動式工業機器人也正在開發中。自動導航汽車已在美國公路上行駛了數百萬公里,去年戴姆勒(Daimler)汽車公司更在內華達州發表全球第一輛自動卡車。

目前我們還不必擔心超級智慧機器會威脅人類存亡。更迫切的問題是如何防止只配備基本語言與AI效能的機器人或機器,可能在無意間傷害人類的生命財產、周遭事物或它們自身。

最大的問題在於機器人的創造者與主人並不可靠。只要是人都會犯錯,因為一時疏忽而下達錯誤或令人困惑的指令,甚至為了私利而蓄意欺騙機器人。正因為人非聖賢,我們必須教導機器人助理與智慧機器該在何時與如何說「不」。

再談機器人三法則

機器人必須遵守人類命令,這道理似乎再簡單不過。科幻小說家艾西莫夫(Isaac Asimov)便把服從人類當做他著名的機器人三法則的基礎。但仔細想想,盲目聽從別人告訴你怎麼做而不管後果,真的是個好主意?當然不是。對機器來說也是如此,尤其機器人可能會按照字面解讀人類命令而不考慮後果。

如果機器人接收的命令牴觸三法則之一「機器人不得傷害人類,或袖手旁觀使人類受傷」,連艾西莫夫都允許它不必聽從主人。此外,他還認為「機器人必須保護自己」,除非這麼做會傷害人類,或是直接反抗人類命令。隨著機器人與智慧機器成為精密而昂貴的人類資產,不論艾西莫夫的法則或常識都告訴我們,如果機器人收到的命令可能會傷害它們自身或周遭人事物,甚至危及主人的安全,機器人必須有能力質疑是否該執行這道命令。

試想家務機器人聽從命令去廚房拿橄欖油,然後回到餐桌淋在沙拉上。忙碌的主人沒注意到機器人還在廚房,便下令倒油,結果機器人把油倒在滾燙的爐子上引起火災。

再試想照護機器人陪伴老婦人去公園,婦人坐在長椅上打瞌睡。當她睡著後,有個惡作劇的人經過,要求機器人替他買披薩。被迫遵從人類命令的機器人立即離去、尋找披薩店,留下老婦人獨自在公園裡無人照料。

又例如在寒冷的冬天早晨,上班遲到的某人準備趕去公司參加重要會議。他搭乘用語音控制的自動車,下令前往辦公室。結冰的路面超出汽車循跡控制系統的負荷,因此自動駕駛系統減緩車速直到遠低於速限以策安全。但他正專心準備會議資料而未注意路況,要求自動車開快點。於是系統提高車速,此時輪胎行駛過一大片冰,導致車輛失控打滑並撞上對向來車。(待續)

(本文由教育部補助「AI報報─AI科普推廣計畫」取得網路轉載授權)

前一篇文章

前一篇文章 下一篇文章

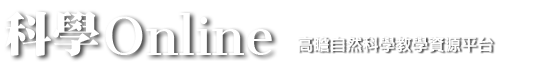

下一篇文章 透過貝葉斯式深度學習建構三維影像模型

透過貝葉斯式深度學習建構三維影像模型  AlphaGo:從棋盤到電網

AlphaGo:從棋盤到電網  「剪」出最有效率的神經網路

「剪」出最有效率的神經網路  照片反光了?讓AI來幫你處理

照片反光了?讓AI來幫你處理  無人車上路前的難題(2/2)

無人車上路前的難題(2/2)  真假之間:GPT-2的危險成就

真假之間:GPT-2的危險成就  利用深度學習找出耐熱珊瑚礁

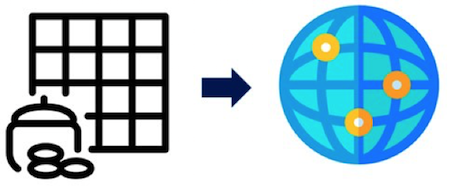

利用深度學習找出耐熱珊瑚礁  新型抗生素開發,機器學習立大功

新型抗生素開發,機器學習立大功