- 藉社群內容預測流感 2019/01/11

藉社群內容預測流感

撰文/Rachel Berkowitz│譯者/張亦葳

轉載自《科學人》2018年5月第195期全世界每年有29萬~65萬人因流感而死,預測流感何時爆發有助於政府官員提早採取行動,以減少相關死亡病例。在最近一項研究中,研究人員僅利用社群媒體的對話內容,便在流感爆發前兩個星期精確做出預測。此項發現理論上能用於最需相關資訊的地區。 Continue reading →

- AI 眼中的世界 2019/01/09

AI 眼中的世界

編譯/台大電機系 吳奕萱人類對周遭環境的感知能力,是藝術創作不可或缺的要素。神經網路在影像辨識上的成效,代表其對見過的物體具有覺察能力。那麼AI的「感知」也可用於創作嗎?電腦科學藝術家將神經網路模型所見以「畫作」實體呈現,一窺機器眼中的世界。 Continue reading →

- 電影推薦大有學問 2019/01/07

電影推薦大有學問

撰文/陳育婷推薦系統在現今社會可說是無處不在。當你在亞馬遜瀏覽網路書店時,網站上的推薦清單讓你更有機會找到有興趣的書籍;影音串流網站Netflix根據你看過的影集及電影給你專屬化推薦,讓你不必煩惱如何選片。推薦系統流派與方法的發展雖已趨於成熟,但在現今科技蓬勃發展、凡事講求快狠準的時代,如何兼顧速度與準確度,有效滿足社會需求,不被企業及消費者淘汰,仍有很大的進步空間。 Continue reading →

- 社群大數據的情緒分析 2018/12/28

社群大數據的情緒分析

講者/陳宜欣(清大資工系副教授)│彙整/《科學人》編輯團隊

轉載自2018.03.11〈科創講堂.AI人工智慧〉

情緒反應了我們的心理狀態,如果處理不好,很可能會造成心理疾病或社會問題,所以許多專家便試圖利用機器學習的技術,從社群的大數據中找出各種情緒表現,希望能及早避免憾事發生。清華大學資訊工程系副教授陳宜欣想出了一種用機器學習來分析情緒的新方法。 Continue reading →

- 公平公正的AI,可能嗎? 2018/12/26

公平公正的AI,可能嗎?

編譯/ 黃柏瑋在這逐漸自動化的世界裡,許多金融或政府機構已開始利用AI來審查貸款、社會福利、簽證,甚至於職缺應徵資格。但AI就像是一面鏡子,如實地反映訓練集中的資料,也難免透露出背後人類固有的偏好與社會不公,導致演算結果對弱勢族群的歧視,甚至因行政效率的提升,加速剝削的發生。「演算法的公平性與透明性」於是逐漸受到重視,歐盟更試圖將「可解釋AI」編入法律,要求所有「個人化自動決策」(Automated Individual Decision-Making)賦予用戶請求解釋的權利,並確保訓練數據的中立,不得讓任何用戶的權益因此受損。只是,如「黑盒子」般神秘又複雜的神經網路,其判斷依據可能就連開發者都理不清。 Continue reading →

- 眼見不為憑:假新聞攻防戰 2018/12/24

眼見不為憑:假新聞攻防戰

編譯/葛竑志假新聞、假消息氾濫的時代來襲,有心人士杜撰的不再只是充滿陰謀論的文字與情節,或是那些容易被看破的粗糙修圖,現在已能借AI之力偽造出以假亂真的影片了。這關乎的不再只是大眾的媒體識讀能力,而是我們人類是否有能力看穿偽造影片背後的真相呢? Continue reading →

- Everything Talk: 飛鏢與聖誕樹的對話 2018/12/21

Everything Talk: 飛鏢與聖誕樹的對話

講者/林一平(交大資工系教授兼副校長)│彙整/《科學人》編輯團隊

轉載自2018.01.14〈科創講堂.ICT資通訊科技〉

物聯網的精神是,每一樣東西都能夠跟其他東西對談(通訊)。但事實上,目前大部分的東西都不能跟其他東西談。大部分物聯網的東西上雲端之後就不知道到哪裡去了。 Continue reading →

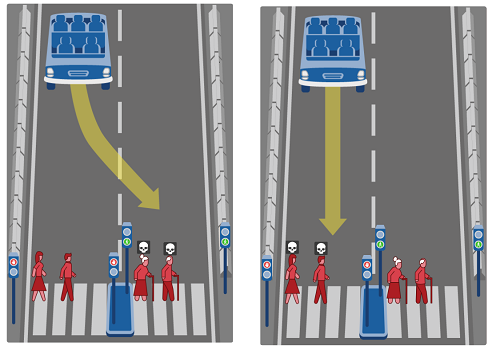

- 自駕車的道德難題 2018/12/19

自駕車的道德難題

編譯/許晉華設想開車開到一半時,油門突然卡死、車子即將失速衝到斑馬線上,此時你會選擇撞上前方正在過馬路的行人,還是左轉犧牲人行道上的小狗呢?這正是經典電車難題(Trolley problem)的變形之一。隨著自駕車技術愈趨成熟,專家開始重視AI面對道德難題時,是否能作出滿足社會期待的倫理決策。MIT Media Lab近期打造出一套線上問卷調查系統─「道德機器」(Moral Machine),整合公眾意見並提高民眾參與討論的意願。 Continue reading →

- AI 眼中的世界 2019/01/09

Insert math as

Additional settings

Formula color

Type math using LaTeX

Preview

\({}\)

Nothing to preview

Insert